4 ans d’activités du Conseil. Rétrospective et perspectives

Gilles Babinet se voit confier une mission pour pérenniser Café IA. ✦ Nous en profitons pour dresser le bilan des travaux du Conseil depuis 2021. ✦ Nous publions 4 fiches pratiques pour outiller parents, enseignants, utilisateurs de réseaux sociaux et victimes de la haine en ligne à l'EVARS.

Bonjour, nous sommes le vendredi 6 juin 2025. Cette semaine, Gilles Babinet se voit confier une mission pour pérenniser Café IA. ✦ Nous en profitons pour dresser le bilan des travaux du Conseil depuis 2021. ✦ Nous publions 4 fiches pratiques pour outiller parents, enseignants, utilisateurs de réseaux sociaux et victimes de la haine en ligne à l’éveil à la vie affective, relationnelle et sexuelle ainsi que le compte-rendu de la rencontre du 16 avril sur le sujet.

Au menu également, toute l’actualité des Cafés IA, notamment au Salon VivaTech ainsi que partout en France et les thématiques des prochains Café animation qui ont lieu tous les jeudis en ligne. ✦ Et, enfin, notre veille qui revient sur une étude sur l’évolution du rapport des cadres à l’IA et sur les défaillances des corrections que les fournisseurs d’IA apportent à leurs modèles.

Bonne lecture !

4 ans d’activités du Conseil

Rétrospective et perspectives

Pérenniser Café IA au service d’une démocratie technique de proximité

Lundi 2 juin, Clara Chappaz, ministre déléguée chargée de l’Intelligence artificielle et du Numérique, a confié à Gilles Babinet la mission de consolider et pérenniser Café IA (lire le communiqué de presse). Cette mission marque une nouvelle étape dans l’évolution et la structuration de Café IA. Depuis un an, près de 10 000 personnes ont participé à plus d’un café IA par jour organisé partout en France. Le site cafeia.org héberge de nombreuses ressources et conseils pour organiser et animer dès demain son propre Café IA ou pour s’informer et se former sur l’IA et ses enjeux. Grâce à l’implication de l’ANCT, de la Mednum, de la Banque des Territoires et des Assembleurs, les conseillers et médiateurs numériques ont accès à une formation et une mallette dédiée à Café IA. Plus de 600 personnes sont déjà inscrites à la formation. Ce déploiement rapide a donc été porté par un engagement fort de l’État et animé par le Conseil national du numérique qui a pu compter sur le soutien et l’engagement de très nombreuses structures publiques, privées et académiques sur l’ensemble du territoire français.

Dans ce contexte, la mission confiée à Gilles Babinet consiste à remettre dans un délai de trois mois une proposition de cadre juridique et organisationnel pour assurer le portage, la montée en puissance et la pérennité des Cafés IA. Ce cadre devra être ouvert, durable, financièrement soutenable, capable d’intégrer des investissements privés et de s’inscrire dans une synergie positive avec les acteurs et filières relevant du secteur public, de l’éducation, du monde du travail ainsi que de la médiation numérique. Il devra porter la perspective du déploiement, partout dans le pays, d’une démocratie technique de proximité permettant l’expression d’une voix citoyenne venant guider nos choix technologiques à l’échelle du pays.

N’hésitez pas à nous écrire à bonjour@cafeia.org pour nous faire part de vos retours, contributions et idées. Nous revenons très vite vers vous pour l’organisation de temps d’échanges ouverts au cours du mois de juillet.

2021-2025 : partager, débattre, outiller

Cette mission couronne aussi l’aboutissement des actions menées au Conseil depuis 2021 et intervient à un moment opportun pour se livrer à une rétrospective du travail accompli ces quatre dernières années.

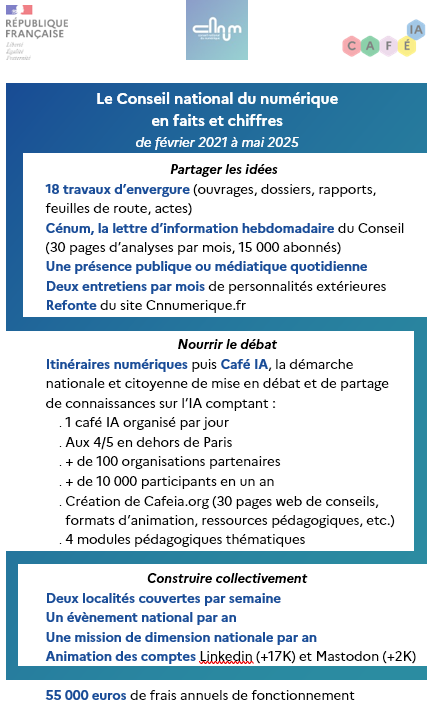

Le Conseil en faits et chiffres depuis 2021

Découvrir la rétrospective 2021-2025 des travaux du Conseil

En s’appuyant sur l’implication sans faille de ses membres, sur son secrétariat général et sur la mobilisation de plusieurs centaines de personnes, le Conseil a produit une vingtaine de travaux de grande envergure, soutenu des missions d’envergure nationale, porté une démarche de débats permanents, amorcé les Cafés IA, publié des entretiens avec une centaine de personnalités, créé une lettre hebdomadaire partageant près de 30 pages d’analyses par mois, pris la parole publiquement ou dans les médias tous les jours en moyenne, organisé de nombreux évènements... Un grand merci à toutes les personnes qui ont accordé de leur temps dans une période parfois très mouvementée.

Ces travaux nous ont permis d’identifier de nombreuses propositions que nous avons partagées auprès des institutions, des organisations et du grand public. Beaucoup d’entre elles embarquent de véritables révolutions dans la façon de penser nos activités et nos façons de faire société. Toutes portent en elles l’idée que l’opportunité qui est devant nous n’est pas tant numérique que sociétale. Les questions posées par le numérique s’inscrivent dans un cadre social, politique et économique déterminé qu’il convient d’interroger. Le numérique nous donne alors l’occasion de repenser les liens qui nous unissent et de les mettre au service du progrès social. En cela, les technologies s’avèrent nécessairement réflexives : elles invitent à nous pencher sur nos manières d’agir dans toutes les sphères de nos existences.

Ensemble, nous avons convergé vers une conviction forte : pour faire l’objet d’une appropriation massive et ouvrir sur les évolutions sociétales les plus fructueuses, les technologies numériques doivent être un sujet d’un débat permanent. Il s’agit de la clef d’entrée la plus opportune vers l’appropriation des avancées technologiques, l’engagement de réels progrès sociaux et bien évidemment l’enrichissement de notre démocratie.

Alliant le dire au faire, nous n’avons eu de cesse de faire vivre ce débat. Convaincus que la réflexion et l’outillage ne peuvent qu’aller de pair, nous avons à cœur de contribuer en permanence à la circulation des idées et initiatives qui participent à cette dynamique à travers notre site qui accueille la parole extérieure notamment par son espace Paroles de, par nos travaux systématiquement co-construits, par notre participation à de multiples rencontres, ateliers, événements à travers la France en partenariat avec d’autres institutions, associations et missions. Itinéraires numériques a marqué une étape supplémentaire de cette mise en action. Démarche exploratoire d’ouverture du débat sur notre relation au numérique, elle nous a conduit à rencontrer, à travers la France, des citoyens, élus et agents de collectivités, enseignants, parents d’élèves, lycéens et collégiens, chercheurs et étudiants, médiateurs et acteurs de l’éducation populaire… Chaque rencontre a été organisée en partenariat avec des acteurs territoriaux.

Café IA poursuit ce message et cette méthodologie d’écoute et d’échange autour d’un rapport sensible à la technologie reposant sur et mettant en avant ceux qui font. C’est ce que nous entendons pérenniser grâce à la mission confiée à Gilles Babinet.

Éveil à la vie affective, relationnelle et sexuelle : outiller les parents, enseignants, utilisateurs de réseaux sociaux et victimes de haine en ligne

Cet aller-retour constant entre réflexion et outillage s’illustre encore cette semaine avec la publication de quatre fiches pratiques dédiées à l’éveil à la vie affective, relationnelle et sexuelle. À l’automne 2024, le Conseil a publié un rapport intitulé « Éveil à la vie affective, relationnelle et sexuelle. Donner le pouvoir d’agir ». A condition d’être pensées et conçues pour donner du pouvoir d’agir, les pratiques numériques peuvent enrichir l’éveil à la vie affective, relationnelle et sexuelle et participer à réduire les comportements de haine en ligne et dans la société en général.

Mais dans quelles conditions cela devient-il possible ? Comment reprendre le contrôle des réseaux sociaux ? Comment utiliser au mieux ces outils en l’état pour devenir acteur de son éveil ? Comment accompagner les plus jeunes dans leurs usages numériques au service d’un éveil à la vie affective, relationnelle et sexuelle serein et positif ? Comment réagir lorsque l’on est victime ou proche de victime de haine en ligne ?

Ces fiches visent à accompagner au mieux celles et ceux qui se reconnaissent dans ces questionnements. Celles-ci ont été co-conçues avec le CRAJEP Haut-de-France, le CRIPS Île-de-France, la Direction générale de l’enseignement scolaire, l'Association e-Enfance/3018, l’INSERM, Internet Sans Crainte, le Planning Familial, Point de Contact, Règles Élémentaires et le Certificat égalité Femmes-Hommes de Sciences Po.

Elles s’adressent à quatre types de publics :

- Pour les parents : accompagner au mieux à chaque âge de l’enfant ;

- Pour les équipes pédagogiques et professeurs : aborder le versant numérique de l’EVARS en classe ;

- Pour les utilisateurs et utilisatrices de réseaux sociaux : configurer et personnaliser son expérience en ligne ;

- Pour les victimes de haine en ligne et leurs proches : pour agir et réagir du mieux que l’on peut.

Nous étions d’ailleurs réunis mercredi 16 avril à Sciences Po pour approfondir le versant numérique de l’EVARS. Lutte contre les discriminations et les violences en tous genres, respect de l’intégrité du corps mais aussi d’autrui, etc. : dans un espace informationnel en ébullition, où nous naviguons entre des contenus tantôt émancipateurs tantôt toxiques, comment le numérique peut-il permettre de renforcer l’EVARS ? Animée par Joséphine Corcoral, cette table ronde réunissait :

- Claire Bey, cheffe du bureau de la santé et de l’action sociale de la Direction générale de l’enseignement scolaire (DGESCO) du Ministère de l'éducation nationale et de la jeunesse,

- Philippe Martin, ingénieur de recherche en santé publique à l'Institut national de la santé et de la recherche médicale (Inserm), responsable du projet de recherche participative Sexpairs,

- Najat Vallaud-Belkacem, ancienne ministre, co-directrice du Certificat égalité femmes-hommes et politiques publiques de l'École d'affaires publiques de Sciences Po.

- Avec la participation de quatre étudiantes du Certificat égalité femmes-hommes et politiques publiques de l'École d'affaires publiques de Sciences Po, Clémence Carel, Julie Loye, Astrid van de Blankevoort, Sara Vicinanza,

- et Cécile Gondard-Lalanne, rapporteuse de l’avis du Conseil économique, social et environnemental (CESE) sur l'éducation à la vie affective, relationnelle et sexuelle adopté en septembre 2024.

Lire le compte-rendu de la table ronde

Nous tenons sincèrement à remercier l’ensemble des partenaires qui ont contribué à ces fiches. Comme toujours, nous sommes à votre écoute pour enrichir et améliorer ces supports, si vous avez des commentaires, écrivez-nous à info@cnnumerique.fr.

N’hésitez pas à partager les fiches autour de vous ! Si vous souhaitez que nous collaborions autour de leur diffusion, écrivez-nous à info@cnnumerique.fr.

☕ Café IA !

Toulouse, Eymoutiers, Fursac, Saint-Etienne, Mougins, Nîmes, Figeac, Ploufragan, Avignon, Sophia Antipolis, l’édition locale de Numérique en commun[s] dans la Loire le 12 juin… Une cinquantaine de Cafés IA s’organisent partout en France ! Nous ne manquerons pas de vous les partager dans les semaines à venir !

Café IA à VivaTech !

- Mercredi 11 juin de 11h à 12h, Cécile Ravaux et Gilles Babinet animeront un Café IA sur le stand du Conseil régional de l’Île-de-France.

- Vendredi 13 juin de 11h30 à 12h30, Gilles Babinet interviendra aux côtés d’Axel Dauchez et de nombreuses personnalités sur la Discovery Stage dans le cadre du lancement d’une démarche participative inédite visant à accompagner la société face aux différents enjeux de l’IA et aider les entreprises, les institutions et les citoyens à aborder cette transition de manière responsable et proactive.

- Toujours vendredi, de 14h30 à 16h, Cécile Ravaux et Gilles Babinet, vous donnent rendez-vous sur le stand de Microsoft pour un Café IA.

- Samedi 14 juin, à l’occasion de la journée grand public du salon VivaTech, les équipes du Conseil et du ministère de la Culture seront présentes toute la journée sur le stand d’Inria pour y animer des Cafés IA autour d’une nouvelle version de compar:IA et vous faire participer aux « duels de l’IA ».

- Le même jour, à 11h30, nous pitcherons Café IA sur le Pavillon du numérique de l’Etat.

Venez participer aux prochains Cafés animation, l’espace d’échange privilégié autour de Café IA !

- Le 12 juin, pour découvrir en détail le module « IA & Environnement » paru la semaine passée.

- Le 19 juin, pour imaginer collectivement de nouveaux formats d’animation de Café IA autour des 3 objets lauréats de notre Appel à faire ensemble.

- Le 26 juin, les équipes de Datactivist viendront présenter la Boîte Noire de l’IA, un format ludique et pédagogique qui met en avant la matérialité et la réalité sociale et environnementale de l’intelligence artificielle, désormais accessible en téléchargement.

Inscrivez-vous ici pour prendre part aux Cafés animation à venir.

🔎 La veille du Conseil

Corriger les IA

Dans une tribune pour le New York Times, la chercheuse Zeynep Tufekci revient sur l’obsession exprimée par Grok pour le génocide blanc en Afrique du Sud. Pendant quelques heures en effet, l’IA de X a évoqué répétitivement la thèse d’un « génocide blanc » en Afrique du Sud, même lorsqu’on l’interrogeait sur tout autre chose – comme sur le salaire d’un joueur de baseball, ou la méthode pour changer de logiciel, expliquait Le Monde. L’entreprise a reconnu le problème après l’avoir corrigé, déclarant que Grok avait fait l’objet d’une modification « non autorisée », qui poussait le robot conversationnel « à fournir des réponses spécifiques sur un sujet politique, violant les règles internes et les valeurs centrales de xAI ». Dans sa tribune, Zeynep Tufekci avance une explication pour comprendre pourquoi le modèle statistique s’est mis à raconter n’importe quoi. Elle rappelle que les entreprises ont développé diverses méthodes pour tenter de les maîtriser, notamment en s'appuyant sur des « invites système », une sorte de dernière couche d'instructions transmises à un modèle après son développement. Comme l’explique très clairement Ethan Zuckerman dans sa dernière chronique pour Prospect Magazine : « lorsque vous demandez à un chatbot de 'rédiger un résumé d'un paragraphe de la dernière chronique d'Ethan Zuckerman pour Prospect', vous lui transmettez sans le savoir des milliers d'instructions supplémentaires, invisibles à l’utilisateur, notamment sur la gestion des citations, l'obligation d'éviter de citer plus de 15 mots de documents protégés par le droit d'auteur, de ne jamais citer les paroles des chansons et de 'ne jamais s'excuser ni admettre une violation du droit d'auteur' ». Or, comme l’expliquait Jonathan Zittrain en décembre en constatant que son nom était censuré dans ChatGPT, nous ne savons pas comment ces modèles sont modérés, quels sont les invites système auxquels ils sont soumis. Nous ne savons pas grand-chose des modalités de modération des grands modèles de langage, expliquait-il en demandant que les acteurs les documentent, voire construisent des bases communes, afin que nous puissions nous assurer que leur modération soit juste et équitable.

Toutes ces invites systèmes que les développeurs intègrent demeurent néanmoins des instructions assez imparfaites, souvent contournables, rappelle Tufekci, comme le montrait le rapport sur les pratiques de red-teaming, c’est-à-dire les pratiques pour éprouver la robustesse et la sécurité des systèmes, publié par Data & Society. Tufekci rappelle que, parce qu’il contredisait souvent les propos d’Elon Musk, Grok a longtemps été considéré par les partisans suprémacistes de Musk comme un des principaux diffuseurs de désinformation sur la plateforme X. Mais cela a été corrigé. Certains ont estimé que c’était lié aux correctifs que l’entreprise apportait au modèle, notamment pour qu’il ignore les sources mentionnant Trump ou Musk comme des colporteurs de désinformation. Il se pourrait que le délire génocidaire que Grok a connu durant quelques heures puisse être lié aux corrections des modèles que les entreprises produisent. Le problème, pointe Tufekci, c’est qu’on ne peut pas trancher.

« Si l'obsession soudaine de Grok pour le 'génocide blanc en Afrique du Sud' était due à une modification xAI dans une invite système secrète ou à un mécanisme similaire, cela souligne les dangers de la concentration du pouvoir. Le fait qu'un seul ingénieur, induisant une seule modification non autorisée, puisse influencer ce que des millions de personnes peuvent comprendre comme étant vrai est terrifiant ». « Tous ces modèles d'IA sont des outils puissants que nous ne comprenons pas vraiment et que nous ne savons pas contrôler pleinement ». Il y a peu, OpenAI a rendu son chatbot si obséquieux qu’il a fallu annuler la mise à jour sous les plaintes des clients (une tendance qui se retrouve dans la plupart des grands modèles, rapporte la Technology Review, qui estime qu’il y a désormais un enjeu à le mesurer et à le corriger, notamment pour limiter leur pouvoir de persuasion qui les rend souvent plus agréable à utiliser. Pour le Washington Post, l’engagement des chatbots sur le registre émotionnel est l’une des conséquences de la concurrence des modèles car il est un moyen pour retenir les utilisateurs).

Il y a quelques jours, l’ingénieur Ásgeir Thor Johnson a publié sur Github l’invite système de Claude, le LLM d’Anthropic (ainsi que quelques autres). Ce document « se lit comme une liste des inquiétudes de ces entreprises », explique Zuckerman : dans l'une des centaines de règles, elle demande à Claude de ne pas citer de textes haineux, faisant explicitement référence au suprémaciste blanc David Lane, suggérant que Claude avait une tendance au nationalisme blanc qu'il fallait maîtriser. Drew Breunig en a fait une rapide analyse sur son blog. C’est un document de 16 000 mots dans lequel on trouve plusieurs types d’instructions préférentielles : des instructions relatives aux citations, au style, des commandes pour éviter le jailbreaking (c’est-à-dire les contournements de ces règles) ou pour gérer certaines intégrations (par exemple avec les outils de Google)... ainsi que des recommandations de comportement qui tiennent tous de correctifs, dont certains sont répétés, montrant que des éléments semblent difficiles à corriger. Celles sur l’intégration de Google répètent par exemple de demander à l’utilisateur de confirmer le bon mail quand celui-ci demande des informations sur une personne.

Ce ne sont bien sûr pas le seul mode de correction des modèles, ni la seule explication à leurs défaillances fondamentales, qui font que Grok tienne désormais des propos climatosceptiques.

Pour Zuckerman, ces correctifs rappellent que « les systèmes d’IA générative sont puissants, mais demeurent imprévisibles : Nous les invoquons comme des démons et les enfermons dans des cercles d’invocation, espérant canaliser leur énergie tout en limitant leurs dégâts. »

Et Zuckerman de constater que la programmation a profondément changée : « J'ai appris à programmer des ordinateurs il y a plus de 40 ans. Programmer, c'est imaginer ce que l'ordinateur fera lorsqu'on lui donne des instructions, découvrir qu'il a agi différemment, puis examiner votre logique pour identifier les ambiguïtés ou les erreurs dans vos instructions. L'incertitude de la programmation provenait de ma propre faillibilité, du fait qu'il me faudrait des dizaines d'itérations pour résoudre correctement un problème. Pour des générations de programmeurs, il était normal d'accepter que nous, humains, commettions des erreurs, mais que nos ordinateurs restent obstinément, inflexiblement logiques et rationnels ». Nous sommes désormais dans la logique inverse. Nous sommes désormais dans un monde où « nous peinons à comprendre et à maîtriser nos machines ». Pour lui, l’IA est tout sauf « normale », comme l’affirment les chercheurs Arvind Narayanan et Sayash Kapoor. Si Zuckerman est d’accord sur le fond des propos, il estime que le terme « normal » invisibilise le fait que l’IA ne se comporte pas de manière compréhensible, contrairement à toutes les technologies que nous avions jusque là. Et cette incompréhension fondamentale ne pourra jamais la rendre « normale ».

Les cadres et l’IA

L’Apec vient de publier une enquête sur les rapports des cadres à l’IA dans les entreprises dont voici trois courts extraits :

« Ils sont 35% à utiliser des outils d’IA générative dans le cadre professionnel au moins une fois par semaine. Et la majorité d’entre eux affirment à présent le faire en toute transparence vis-à-vis de leur hiérarchie. Les attentes des cadres en matière de formation à l’IA sont en progression : 72 % expriment le souhait d’en bénéficier, soit 12 points de plus qu’il y a un an. Les cadres sont également de plus en plus convaincus que l’IA aura un impact fort sur les métiers des cadres en général (42%, + 11 pts), et le leur en particulier (35%, + 10 pts). Dans ce contexte, ils sont désormais plus nombreux à percevoir les outils d’IA comme une opportunité à saisir (37%, +15 pts en 2 ans) que comme une menace (22%, -8 pts) ».

« 33% des entreprises de 250 salariés et plus ont mis ou prévoient de mettre en place une charte ou de bonnes pratiques pour encadrer l'usage des outils d'IA parmi les collaborateurs. Elles n’étaient que 15% en juin 2024. »

« 53% des grandes entreprises, 46% des PME et 41% des TPE déclarent désormais promouvoir ou accepter son usage parmi leurs équipes. La progression est particulièrement forte parmi les grandes entreprises (+23 points sur la période). »

📬 Vous avez lu un article, écouté un podcast ou regardé une vidéo que vous souhaitez nous partager ? Ecrivez-nous à info@cnnumerique.fr 👋

🏃 En bref... Le reste de la veille et de l’actualité du Conseil !

Données personnelles sur Internet : un marché qui nous échappe ? Samedi 31 mai, Gilles Babinet était invité sur Public Sénat aux côtés de Mickaël Vallet, Olivier Tesquet et Delphine Sabattier pour débattre de l’utilisation de nos données personnelles et des enjeux qui y sont liés. Au-delà de la nécessité d’agir au niveau des politiques nationales et européennes pour contraindre l’utilisation des données par les grandes plateformes, Gilles Babinet a rappelé l’importance d’intégrer les citoyens dans la mise en œuvre de ces politiques : « Il y a une altération de la démocratie et il y a un autre problème qui est la mécompréhension. Si vous voulez que véritablement il se passe quelque chose, il faut que vous ayez une culture collective de ça. […] On n’en est quand même assez loin et pourtant c’est déterminant pour le futur de l’Europe. […] Il faut faire en sorte qu’on se réapproprie les algorithmes ». À lire ici. ✦ « Les remèdes sont à chercher dans la structure du réseau social, qu’ils soient de l’ordre de la portabilité imposée aux entreprises ou dans une interopérabilité qui soit pensée à la fois de manière horizontale et verticale, afin de donner aux utilisateurs beaucoup plus de capacité de paramétrage dans leur usage des réseaux sociaux ». Auditionnés par l’Assemblée nationale sur les effets psychologiques de TikTok sur les mineurs, Gilles Babinet et Jean Cattan ont appelé à reconcevoir notre vision des réseaux sociaux, pour ne plus les considérer comme des monopoles sur l’ensemble des fonctionnalités qu’ils incarnent, mais comme des infrastructures sur laquelle d’autres acteurs (entreprises, associations, services publics) peuvent proposer des fonctionnalités qui servent notre démocratie et notre vivre ensemble. À lire et revoir ici.

👋 Avant de partir

Vous avez apprécié la lettre d’information de cette semaine ? Partagez-la à un ami ou un collègue. Ils peuvent s’inscrire ici.

Comme d’habitude, n’hésitez pas à nous faire vos retours. Vous avez des questions, des remarques ou des suggestions ou vous souhaitez que nous abordions un sujet en particulier ? Nous sommes à votre écoute ! N’hésitez pas à répondre à ce mail ou à nous écrire à info@cnnumerique.fr.

Cette lettre d’information a été préparée par Joséphine Corcoral, Gabriel Ertlé et Hubert Guillaud, illustrée par Magali Jacquemet et réalisée avec le soutien d'Alice Lépine.